Je me souviens des débuts du dessin animé 3D (Toy Story 1, pour moi) et du moment où les effets de lumière ont commencé à être de plus en plus complexes, ajoutant un vraie dimension à l’ensemble des modélisations texturées (regardez à la fin d’un Pixar, le nombre de personnes qui bossent uniquement sur la lumière). Je fais un lien entre cette technique qui ajoute de la profondeur et le travail sur la position dans l’espace des différents bruitages et ambiances d’une fiction sonore qui vont la rendre réaliste et crédible. La panoramique est la lumière de l’audio. Voici un petit « tuto » sur la gestion de la spatialisation dans la saga Le Vaisseau. Quand on veut travailler sur l’ambiance d’un lieu, il faut que ce lieu devienne réel, au moins dans notre tête, pour pouvoir le retranscrire ensuite à l’audio. Pour Le Vaisseau, j’ai essayé de penser les lieux non seulement en largeur mais aussi en profondeur et parfois en hauteur, une spatialisation 3D. J’ai préparé quelques exports pour vous montrer les différentes étapes. Dans la réalité, je ne suis pas ces étapes, je place un par un mes éléments sans attendre que tous soient là avant de passer à la suite. Pour des soucis de compréhension sur ce « tutoriel », j’ai séparé le mixage en grandes parties.

Le Panoramix

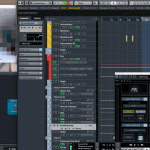

Première étape évidemment, le mixage en panoramique qui correspond à placer les différents sons dans le champ stéréo (plus à gauche, à droite). Je ne vais pas rester très longtemps sur ce passage. Notez quand même qu’il est parfois intéressant de couper la panoramique complètement (passer en mono) pour écouter ce que les sons donnent ensemble et retravailler ensuite leur volume et leur placement. J’ai choisi, pour illustrer mes étapes, un extrait du Vaisseau, quand Isaac entre pour la première fois dans le dock des capsules que j’imagine comme un hangar de taille moyenne plutôt vide. Voici donc la scène sans travail sur la panoramique (mais en stéréo).

Il s’agit ensuite de placer simplement à droite ou à gauche et plus ou moins loin les différents éléments. Ce qui donne ceci.

La Profondeur

Ensuite, il va falloir donner une impression de distance entre les éléments. Le Vaisseau est une fiction « à la première personne » et je considère donc que la tête de l’auditrice-teur est à la place de celle d’Isaac. Pour gérer la profondeur, l’utilisation de réverbération va permettre de donner une appréciation de la distance mais aussi de la taille de la pièce et des éléments qui sont présents dedans (peu de reverberation = petite pièce ou pleine de fournitures…). Pour cette fiction, j’ai créé un groupe par lieu. Ici le groupe « Hangar » possédait une réverbération 2C-Aether (un pré-réglage, boooouh). J’envoie chaque piste de son dans ce groupe par le biais d’un effet send (lié au pan de la piste). Exemple en photo : le bip qu’on entend au fond à droite du hangar. Voici donc le résultat avec toutes les reverberations appliquées. On pourrait très bien s’arrêter ici pour se dire que la saga est spatialisée. Comme je voulais la rendre immersive, j’ai continué encore un peu.

Ensuite, il va falloir donner une impression de distance entre les éléments. Le Vaisseau est une fiction « à la première personne » et je considère donc que la tête de l’auditrice-teur est à la place de celle d’Isaac. Pour gérer la profondeur, l’utilisation de réverbération va permettre de donner une appréciation de la distance mais aussi de la taille de la pièce et des éléments qui sont présents dedans (peu de reverberation = petite pièce ou pleine de fournitures…). Pour cette fiction, j’ai créé un groupe par lieu. Ici le groupe « Hangar » possédait une réverbération 2C-Aether (un pré-réglage, boooouh). J’envoie chaque piste de son dans ce groupe par le biais d’un effet send (lié au pan de la piste). Exemple en photo : le bip qu’on entend au fond à droite du hangar. Voici donc le résultat avec toutes les reverberations appliquées. On pourrait très bien s’arrêter ici pour se dire que la saga est spatialisée. Comme je voulais la rendre immersive, j’ai continué encore un peu.

Les débuts du mastering

Je ne suis pas fier de moi, mais pour cette saga… j’ai recommencé à faire le master dans le projet. En suivant cependant une règle très simple (évoquée avec Walter Proof à la MP3àParis) : le couper fréquemment pour vérifier qu’il n’y a pas de problème. J’ai donc utilisé Izotope Ozone pour le master et ajouté le très bon plugin Imager pour « pousser les murs ». J’ai aussi testé sur cet épisode 2 un nouveau plugin de chez Waves : le NX. Il s’agit à l’origine d’un plugin qui permet aux personnes qui mixent au casque de donner l’impression d’être dans un pièce. J’ai utilisé le plugin sur tous les sons qui étaient autour d’Isaac pour donner l’impression que vous êtes à sa place. Voici donc 2 exports différents. le premier est mon export masterisé et avec le NX. Vous y entendrez que l’espace sonore s’est agrandi.

Je ne suis pas fier de moi, mais pour cette saga… j’ai recommencé à faire le master dans le projet. En suivant cependant une règle très simple (évoquée avec Walter Proof à la MP3àParis) : le couper fréquemment pour vérifier qu’il n’y a pas de problème. J’ai donc utilisé Izotope Ozone pour le master et ajouté le très bon plugin Imager pour « pousser les murs ». J’ai aussi testé sur cet épisode 2 un nouveau plugin de chez Waves : le NX. Il s’agit à l’origine d’un plugin qui permet aux personnes qui mixent au casque de donner l’impression d’être dans un pièce. J’ai utilisé le plugin sur tous les sons qui étaient autour d’Isaac pour donner l’impression que vous êtes à sa place. Voici donc 2 exports différents. le premier est mon export masterisé et avec le NX. Vous y entendrez que l’espace sonore s’est agrandi.

Dans ce deuxième extrait, je coupe puis ré-enclenche le NX, quand on le coupe, c’est comme si le son se serrait sur les oreilles. J’ai appliqué le NX uniquement aux sons du hangar, le bruit du moteur qu’on entend ne varie pas car il est, selon moi, global dans le vaisseau.

Dans ce deuxième extrait, je coupe puis ré-enclenche le NX, quand on le coupe, c’est comme si le son se serrait sur les oreilles. J’ai appliqué le NX uniquement aux sons du hangar, le bruit du moteur qu’on entend ne varie pas car il est, selon moi, global dans le vaisseau.

Pour l’épisode 2 je me suis arrêté à ce travail. Pour moi, l’ambiance est prenante et immersive comme je l’attendais. Mais… mais j’ai une autre idée pour la suite.

La réalité sonore virtuelle

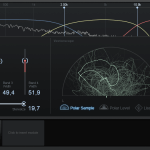

Le principe de fonctionnement du NX est simple, il utilise votre webcam pour reconnaitre et tracker votre tête (voir image). Quand vous tournez la tête à gauche, vous vous placez face à ce qui vient de ce coté. Vous partez à droite et vous vous déplacez dans l’espace. Le plugin ne permet pas d’enregistrer les mouvements de la tête comme automation, ce qui est embêtant, mais comme il y a un signal généré, on peut l’enregistrer en sortie audio sur une nouvelle piste. Ce que j’ai fait dans ce dernier extrait où j’impose à l’auditeur les mouvements de tête d’Isaac. Je n’ai pas osé le faire dans l’épisode de peur que cela « sorte » les auditeurs de la fiction. Mais je trouve l’expérience amusante et je ne dis pas que je ne le ferai pas plus tard (ou dans un autre projet). Encore une fois, seuls les sons proches d’Isaac sont concernés, il faut donc tendre une oreille attentive pour découvrir l’effet.

J’espère vous avoir convaincu que prendre le temps de travailler sur cette partie de la création audio est une étape essentielle pour obtenir un rendu immersif !